关于 openai sora 的一些思考

@雷斯林 Raist:关于 openai sora 的一些思考:

1,你只要打一段话就能生成堪比好莱坞质感的视频,这无疑是生产力的提高。

过去要做出这样作品,得是相当专业的一只视频团队,花费数十万美金数百个小时。

现在任何人只要会打字就能生成。

这让人兴奋。

2,当然,网络上也再没有真实可言。

如果说 ps 让照片再也不可信,之前的 ai 让 60% 的视频不可信的话。那现在网上你看到的所有视频、图片、文字,都有可能是 ai 生成的。

所谓 “真实” 这个概念,以后就不存在了。你相信的将是别人的信用,而不是其他。

得尽快让大家意识到这一点,尤其是父母长辈。否则很容易被骗。

骗子用你形象给父母打视频电话,完全看不出破绽,谁又能分辨呢。

3,这是内容创作者的变革期,充满了机遇。有人说写作能力越来越重要,但我持悲观态度。

最大的挑战在于,ai 已经不是被动地当个工具了。你能创作的东西,他们也能创作。而且在使用 Sora 上,你大概率是没有 ai 自己专业的。

大公司的规模效应会越来越明显,ai 必定会淘汰大多数普通创作者。

过去这么些年,其实我们很多博主的机会,是大型平台公司给的。他们无法提供足够的内容,于是创建平台让你来发内容。

但如果类似抖音的平台公司可以自己用 ai 生成视频娱乐大众,他们何必要和内容创作者分一杯羹呢?

或者往更大一个层面去说。

未来会不会有一个全知全能的 ai 服务系统全人类,我们只消费就好,完全不需要创造呢?

这么个牛逼的系统,我们就叫它 “天网” 吧。

总觉得人类正一步步走向几十年前我们自己想象出的结局。

4,之前我们常说科技要取代体力劳动,未来都是机器人负责干重活,人类写诗、唱歌、画画,做有创意的事情。

但现在看来,完全相反。

机器马上要取代人类做创意工作了,而瓦工水电工等体力活还是人类做,而且收入越来越高了。

我们经常说人类有创造型思维而机器只会在别人的素材基础上发挥。

但仔细想想,其实人类所谓的创作,绝大多数时候也就是把前人的经验结合在一起。所有我们看来 “创新” 的东西,都有无数前人的影子。人类几万年的文明史,在前人的经验上一步步走到了现在。

现在机器把这一过程加速了几千几万倍。

就和自动驾驶一样的。

自动驾驶不需要做到完美,它只要比人类驾驶员靠谱就行。如果说完美是 100%,自动驾驶做到了 10%,普通人类驾驶员最多做到了 4%。

绝大多数创作者,能交出来的也不过是五六分的东西,AI 一瞬间把他们全淘汰了

@琉玄:昨天的 AI 是一键成图,今天的 AI 已经可以根据你提供的一句话一键生成一段视频了。

我看到群里的大家热闹地聊起来,有的人觉得是好事情,以后一个人就是一个团队,有的人表示非常绝望,将有更多人失业。

大家争执了起来。

有创意输出类的从业人员紧跟着说:“更多人失业?已经很多人失业了。”

是的。这也是我亲眼所见,AI 不在未来,它是已经融入我们的生活了,当它可以一键成图的那瞬间,我就在地铁里、在电梯里,看到完全 AI 生成的海报了。

我看得真是惊心动魄,合家福的广告画面里每一张大笑的都是虚构人脸,这一张图背后失业的是策划、文案、摄影、模特、修图、作画、排版……

很多人说 AI 作图有很多漏洞,比如手指头、衣服的皱褶等等,先不说这些漏洞正在攻克中,就,这些漏洞,有人在乎吗?我看一张海报里的人物骑在龙身上,这个人物没有下半身,我看到了,我一笑而过,仅仅吐槽了句 “真丑”。没人在乎。

以前我就说过,大多数人吃个五六分的东西就行了,十分的大师作品,他们其实不吃的,所以 AI 生成的东西已经足够填饱大多数人们的需求。

而绝大多数创作者,能交出来的也不过是五六分的东西,原本他们每一个人坐在自己的工位上,还能靠这五六分的技术实力吃饭,现在 AI 一瞬间把他们全淘汰了,以后他们上哪儿去呢?

不知道。

但是 AI(科技)的发展,势不可挡。

未来怎么样……

到时候再看吧。

效果炸裂!OpenAI 首个视频生成模型发布,网友:整个行业 RIP

刚刚,奥特曼发布 OpenAI 首个视频生成模型 Sora。

完美继承 DALL・E 3 的画质和遵循指令能力,能生成长达 1 分钟的高清视频。

AI 想象中的龙年春节,红旗招展人山人海。

有紧跟舞龙队伍抬头好奇官网的儿童,还有不少人掏出手机边跟边拍,海量人物角色各有各的行为。

雨后东京街头,潮湿地面反射霓虹灯光影效果堪比 RTX ON。

行驶中的列车窗外偶遇遮挡,车内人物倒影短暂出现非常惊艳。

也可以来一段好莱坞大片质感的电影预告片:

竖屏超近景视角下,这只蜥蜴细节拉满:

网友直呼 game over,工作要丢了:

甚至有人已经开始 “悼念” 一整个行业:

AI 理解运动中的物理世界

OpenAI 表示,正在教 AI 理解和模拟运动中的物理世界,目标是训练模型来帮助人们解决需要现实世界交互的问题

根据文本提示生成视频,仅仅是整个计划其中的一步。

目前 Sora 已经能生成具有多个角色、包含特定运动的复杂场景,不仅能理解用户在提示中提出的要求,还了解这些物体在物理世界中的存在方式。

比如一大群纸飞机在树林中飞过,Sora 知道碰撞后会发生什么,并表现其中的光影变化。

一群纸飞机在茂密的丛林中翩翩起舞,在树林中穿梭,就像候鸟一样。

Sora 还可以在单个视频中创建多个镜头,并依靠对语言的深入理解准确地解释提示词,保留角色和视觉风格。

美丽、白雪皑皑的东京熙熙攘攘。镜头穿过熙熙攘攘的城市街道,跟随几个人享受美丽的雪天并在附近的摊位购物。绚丽的樱花花瓣随着雪花随风飘扬。

对于 Sora 当前存在的弱点,OpenAI 也不避讳,指出它可能难以准确模拟复杂场景的物理原理,并且可能无法理解因果关系。

例如 “五只灰狼幼崽在一条偏僻的碎石路上互相嬉戏、追逐”,狼的数量会变化,一些凭空出现或消失。

该模型还可能混淆提示的空间细节,例如混淆左右,并且可能难以精确描述随着时间推移发生的事件,例如遵循特定的相机轨迹。

如提示词 “篮球穿过篮筐然后爆炸” 中,篮球没有正确被篮筐阻挡。

技术方面,目前 OpenAI 透露的不多,简单介绍如下:

Sora 是一种扩散模型,从噪声开始,能够一次生成整个视频或扩展视频的长度,

关键之处在于一次生成多帧的预测,确保画面主体即使暂时离开视野也能保持不变。

与 GPT 模型类似,Sora 使用了 Transformer 架构,有很强的扩展性。

在数据方面,OpenAI 将视频和图像表示为 patch,类似于 GPT 中的 token。

通过这种统一的数据表示方式,可以在比以前更广泛的视觉数据上训练模型,涵盖不同的持续时间、分辨率和纵横比。

Sora 建立在过去对 DALL・E 和 GPT 模型的研究之上。它使用 DALL・E 3 的重述提示词技术,为视觉训练数据生成高度描述性的标注,因此能够更忠实地遵循用户的文本指令。

除了能够仅根据文本指令生成视频之外,该模型还能够获取现有的静态图像并从中生成视频,准确地让图像内容动起来并关注小细节。

该模型还可以获取现有视频并对其进行扩展或填充缺失的帧,请参阅技术论文了解更多信息(晚些时候发布)。

Sora 是能够理解和模拟现实世界的模型的基础,OpenAI 相信这一功能将成为实现 AGI 的重要里程碑。

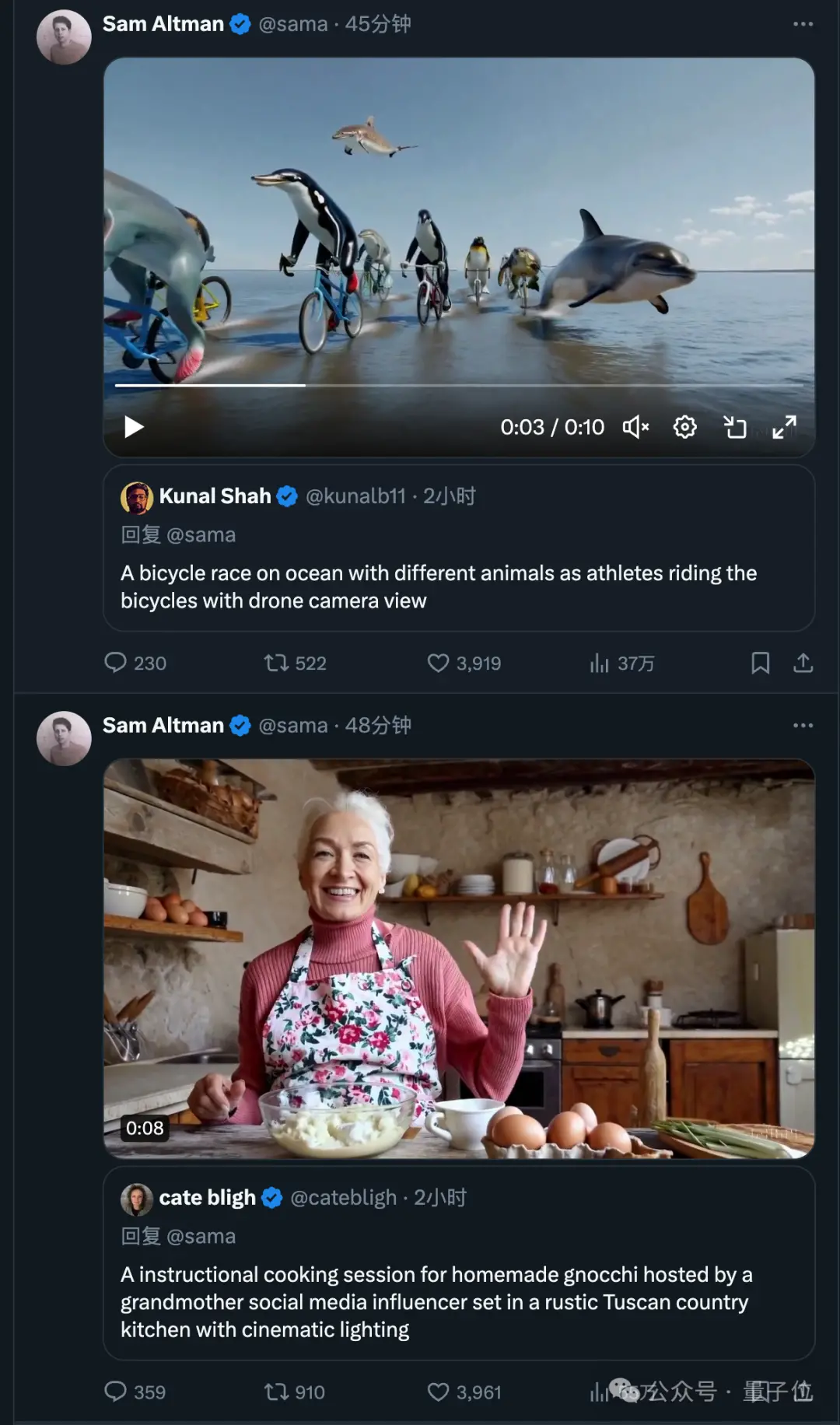

奥特曼在线接单

目前已有一些视觉艺术家、设计师和电影制作人(以及 OpenAI 员工)获得了 Sora 访问权限。

他们开始不断 po 出新的作品,奥特曼也开始了在线接单模式。

带上你的提示词 @sama,就有可能收到生成好的视频回复。

来源:量子位 微信号:QbitAI