阿里Qwen团队正式发布他们最新的研究成果——QwQ-32B大语言模型。

这是一款拥有320亿参数的模型,其性能可与具备6710亿参数(其中370亿被激活)的DeepSeek-R1媲美。

QwQ-32B在仅有DeepSeek-R1约1/21参数量的情况下,用强化学习实现了性能上的跨越。

此外,阿里还在推理模型中集成了与Agent相关的能力,使其能够在使用工具的同时进行批判性思考,并根据环境反馈调整推理过程。

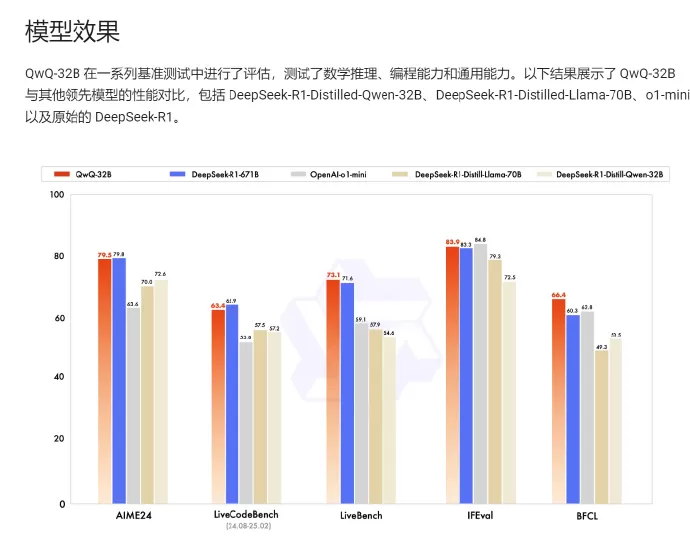

QwQ-32B 在一系列基准测试中进行了评估,测试了数学推理、编程能力和通用能力。

其中,在测试数学能力的AIME24评测集上,以及评估代码能力的LiveCodeBench中,千问QwQ-32B表现与DeepSeek-R1相当,远胜于o1-mini及相同尺寸的R1 蒸馏模型。

同时,在由Meta首席科学家杨立昆领衔的“最难LLMs评测榜”LiveBench、谷歌等提出的指令遵循能力IFEval评测集、由加州大学伯克利分校等提出的评估准确调用函数或工具方面的BFCL测试中,千问QwQ-32B的得分均超越了DeepSeek- R1。

目前,QwQ-32B已在Hugging Face和ModelScope开源,大家也可通过Qwen Chat直接进行体验!

据阿里云发布的QwQ-32B模型信息,该模型经过量化优化后,支持消费级显卡本地部署 ,具体要求如下:

显存需求 :

模型量化后对显存要求大幅降低,20GB以上显存 的消费级显卡即可满足部署需求。例如:

NVIDIA GeForce RTX 2080 Ti (22GB显存)9

RTX 3060/3070/3080 或 RTX 4060/4070 系列(需显存≥20GB)48

性能对比 :

相比DeepSeek-R1模型需要70GB显存(需3张RTX 4090),QwQ-32B通过量化技术显著降低了硬件门槛,使得普通用户也能在本地运行性能接近R1满血版的模型15。

部署优势 :

阿里云明确表示,QwQ-32B通过技术优化(如强化学习改写)实现了“消费级显卡友好”,且已开源(Apache 2.0协议),用户可通过通义App或网页版直接体验